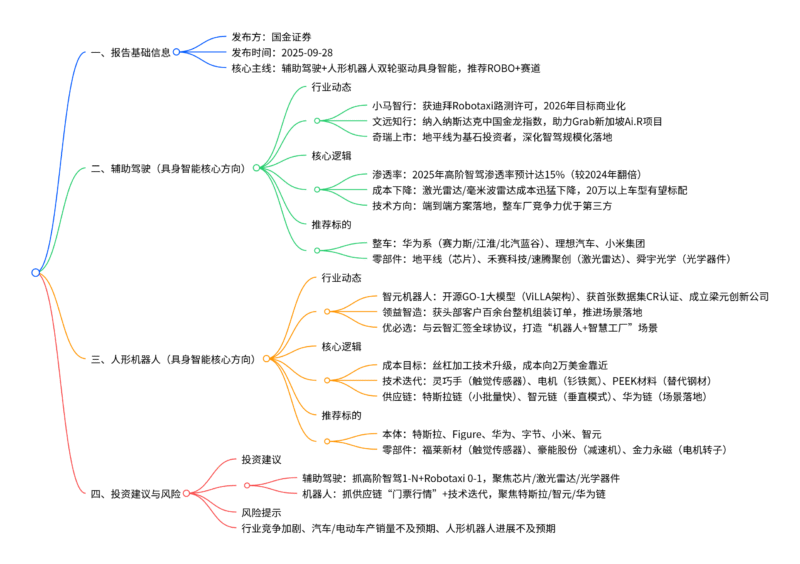

26年算力景气度持续上行,关注互联、液冷、供电板块

【原报告在线阅读和下载】:20260121【MKList.com】AI产业链系列报告一:26年算力景气度持续上行,关注互联、液冷、供电板块 | 四海读报

【迅雷批量下载】:链接:https://pan.xunlei.com/s/VOXJ23RJHhoECPL5FRrVathfA1 提取码:umqb

【夸克批量下载】:链接:https://pan.quark.cn/s/fe42cc605010 提取码:j4Vv

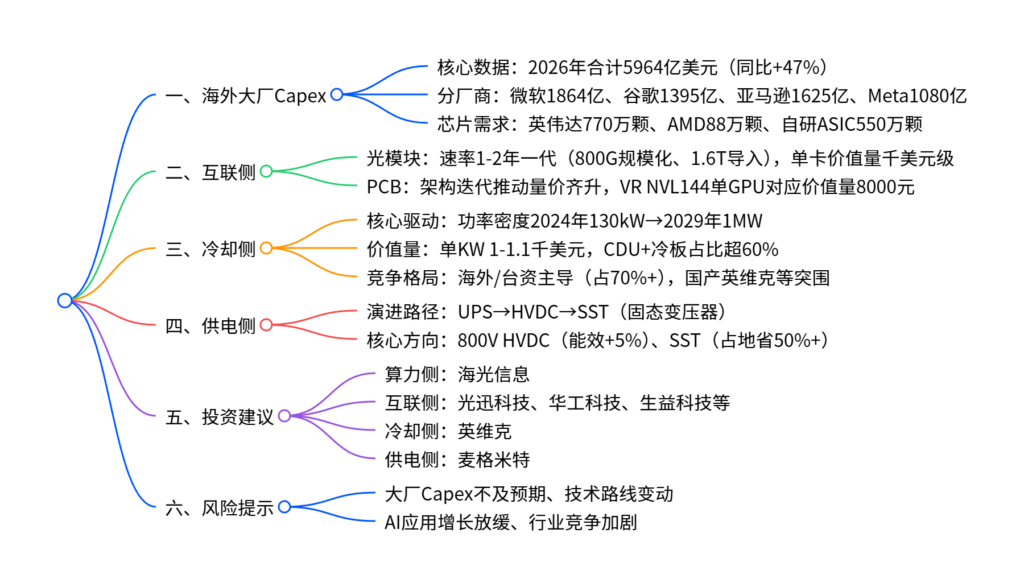

1. 一段话总结

2026年AI算力景气度持续上行,海外微软、谷歌等四大厂资本开支(Capex)预计达5964亿美元(同比+47%),AI算力及基础设施投入占比持续提升;核心受益板块集中于互联侧(光模块800G规模化、1.6T导入,PCB量价齐升)、冷却侧(AI GPU机架功率密度2029年将突破1MW,液冷成刚需,单KW价值量1-1.1千美元)、供电侧(AIDC供配电路径向HVDC、SST演进);芯片需求以英伟达为主(2026年出货770万颗),AMD及海外大厂自研芯片快速放量;投资聚焦海光信息、光迅科技、英维克等标的,需警惕大厂Capex不及预期、技术路线变动等风险。

2. 思维导图(mindmap)

3. 详细总结

一、海外大厂Capex:算力投入驱动高增长

-

整体规模预测

-

2025年四大厂(微软+谷歌+亚马逊+Meta)Capex合计4065亿美元(同比+46%),2026年预计增至5964亿美元(同比+47%),AI算力及基础设施为核心投入方向。

-

分厂商Capex及增速:

厂商 2025E Capex(亿美元) 2026E Capex(亿美元) 2026E同比增速 微软 1165 1864 60% 谷歌 930 1395 50% 亚马逊 1250 1625 30% Meta 720 1080 50%

-

-

芯片需求测算

- 英伟达:2026年出货量770万颗(B300系列490万颗、R200系列280万颗),仍是核心采购选择。

- AMD:MI400系列表现亮眼,出货量88万颗(MI355 12万颗、MI400 76万颗)。

- 自研ASIC:谷歌TPU(328万颗)、亚马逊Trainium(151万颗)、微软Maia(40万颗)、Meta MTIA(30万颗)合计出货550万颗,快速放量。

二、互联侧:光模块+PCB量价齐升

(一)光模块:速率迭代+价值量提升

- 技术迭代:端口速率按“1-2年一代”演进(10G/40G→100G/400G→800G/1.6T),AI训练集群规模从几十卡扩展至数百卡,驱动用量、规格同步升级。

- 价值量:单张AI加速卡对应光模块价值量达千美元级(B200/B300约2100美元,R200超4000美元),光互连在单柜/单Pod投入代际翻倍。

- 未来趋势:800G加速规模化部署,1.6T进入导入期,LPO/CPO、硅光技术推动“低功耗、高密度”演进。

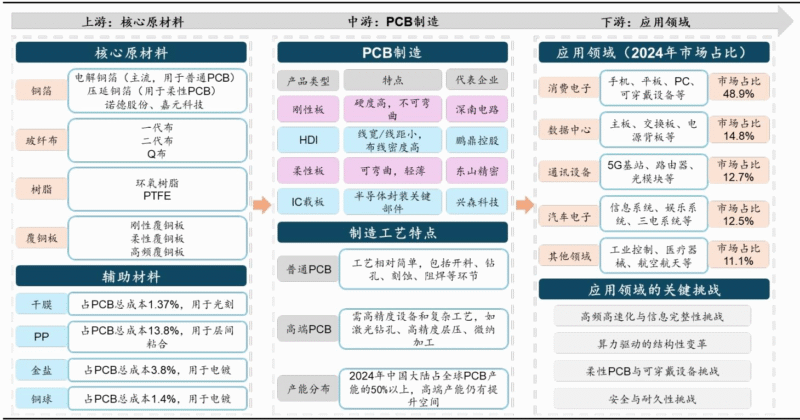

(二)PCB:架构迭代催生增量

-

需求逻辑:算力架构向正交化、无线缆化演进,信号链条缩短,PCB成为核心互联与供电载体,AI服务器集群推动需求量、单价双升。

-

价值量拆分:

架构 单机柜PCB价值量(万元) 单GPU对应价值量(元) GB200 NVL72 23-25 约2900 VR NVL144 CPX 47-51.5 约8000

三、冷却侧:液冷成高功率密度刚需

-

核心驱动:AI GPU功率持续提升(英伟达B200 1000W、GB300 1400W、R200 1.8-2.3kW),机架功率密度2024年130kW→2029年1MW,液冷为唯一可行方案。

-

价值量测算:

芯片型号 单GPU液冷价值量(美元) 单KW液冷价值量(美元/KW) GB200 1110 1110 GB300 1409 1006 R200 2400 1100+ -

产业链竞争:

- 海外/台资主导:双鸿、奇宏(AVC)、酷冷至尊等占据全球70%+液冷组件份额,聚焦冷板、CDU、快接头等核心环节。

- 国产突围:英维克UQD进入英伟达供应链,申菱环境、高澜股份凭借定制化服务、成本优势抢占份额。

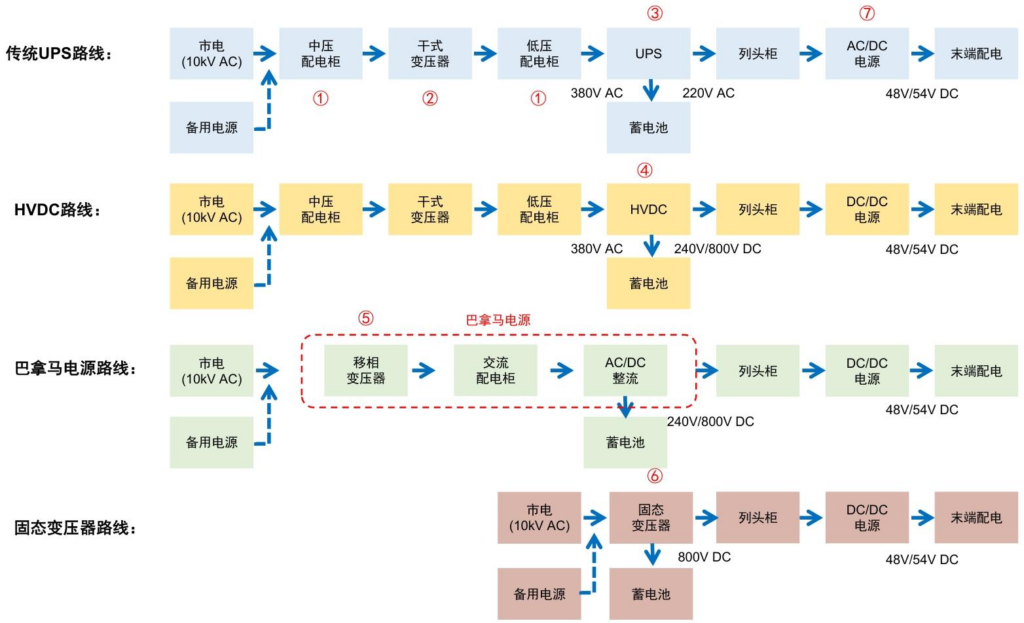

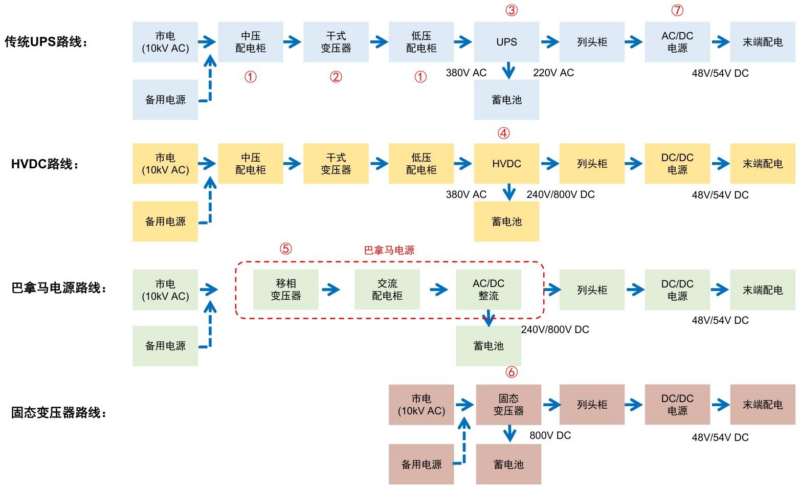

四、供电侧:AIDC供配电路径演进

-

核心痛点:传统UPS方案占地大(单机柜30kW时配电房面积达2.5万m²)、效率低、用铜量大,无法适配AI服务器高功率需求。

-

演进路径:UPS→HVDC→SST(固态变压器)

- HVDC:800V架构成为主流,英伟达推动2027年导入,能效提升5%、用铜量减少45%,单位价值量5-6亿元/GW。

- SST(固态变压器):终局方案,直接实现10kV交流→800V直流转换,效率达98%,占地省50%+、用铜量省90%+,单位价值量约10亿元/GW。

五、投资建议与风险提示

-

投资建议

- 算力侧:海光信息(国产AI芯片核心标的);

- 光模块:光迅科技、华工科技;

- PCB:生益科技、胜宏科技、沪电股份、鹏鼎控股;

- 液冷:英维克;

- 供电侧:麦格米特(HVDC+SST布局)。

-

风险提示

- 互联网大厂Capex不及预期;

- 英伟达及头部AI ASIC厂商技术路线变动;

- AI应用活跃用户增长放缓;

- 行业竞争加剧导致毛利率下滑。

4. 关键问题及答案

问题1:2026年海外大厂Capex增长对AI产业链的核心拉动作用体现在哪些方面?对应的芯片需求结构如何?

- 答案:核心拉动作用:①直接驱动AI算力基础设施建设,带动互联(光模块、PCB)、冷却(液冷)、供电(HVDC、SST)等配套环节需求爆发;②推动芯片市场多元化,英伟达仍为主力,AMD及自研ASIC快速放量。芯片需求结构:①英伟达占主导,2026年出货770万颗(B300 490万颗+R200 280万颗),适配各类AI训练/推理场景;②AMD MI400系列出货88万颗,成为补充选择;③海外大厂自研ASIC合计出货550万颗,谷歌TPU、亚马逊Trainium等在自有生态中规模化应用,形成“英伟达+AMD+自研”三足鼎立格局。

问题2:液冷成为AI算力中心刚需的核心原因是什么?其价值量分布及竞争格局有何特点?

- 答案:核心原因:AI GPU功率持续飙升(从1000W升至2.3kW),机架功率密度2029年将突破1MW,传统风冷无法满足散热需求,液冷是唯一能适配高功率密度的方案。价值量分布:CDU(占比35%+)和冷板(占比26%-30%)为核心环节,单KW液冷价值量1-1.1千美元(R200超1100美元)。竞争格局:①海外/台资主导,双鸿、奇宏(AVC)等占据全球70%+组件份额,绑定英伟达等核心客户;②国产厂商突围,英维克UQD进入英伟达MGX生态,申菱环境、高澜股份凭借定制化服务、成本优势,在谷歌、Meta等CSP客户中抢占份额。

问题3:AIDC供配电领域的演进路径是什么?各阶段核心技术的优势及标的有哪些?

- 答案:演进路径:传统UPS→HVDC(高压直流)→SST(固态变压器),核心围绕“减占地、提效率、省用铜”三大目标。各阶段特点及标的:①UPS阶段:当前主流,但占地大、效率低,标的包括科华数据、科士达;②HVDC阶段:过渡核心,800V架构能效提升5%、用铜量减45%,2026年试点落地,标的包括科华数据、中恒电气、麦格米特;③SST阶段:终局方案,效率达98%、占地省50%+,2026年国内外试点催化,标的包括四方股份、为光能源、中国西电。

暂无评论内容