阿里云2025年AI应用(AI Agent)开发新范式报告重点总结

报告原文:https://report.mklist.com/book/36029

该报告聚焦阿里云在AI应用(AI Agent)开发领域的新范式,围绕核心架构、关键技术支撑、实践路径及企业价值展开,系统阐述了从技术组件到落地实践的完整解决方案,核心重点如下:

![图片[1]-阿里云2025年AI应用(AI Agent)开发新范式报告-四海清单](https://mklist.com/wp-content/uploads/2025/08/image-1-1024x534.png)

一、AI应用核心架构:AI Agent + LLM双引擎模式

AI应用的核心是实现从“被动工具”到“智能伙伴”的进化,核心架构依赖AI Agent与LLM(大语言模型)的协同闭环,二者分工明确且深度联动:

- LLM:认知核心(“大脑”)

负责所有“思考”类任务,包括精准理解用户自然语言意图(如解析“分析销售数据”的模糊需求)、将目标拆解为清晰有序的执行步骤,是AI应用的决策中心。 - AI Agent:执行核心(“手脚”)

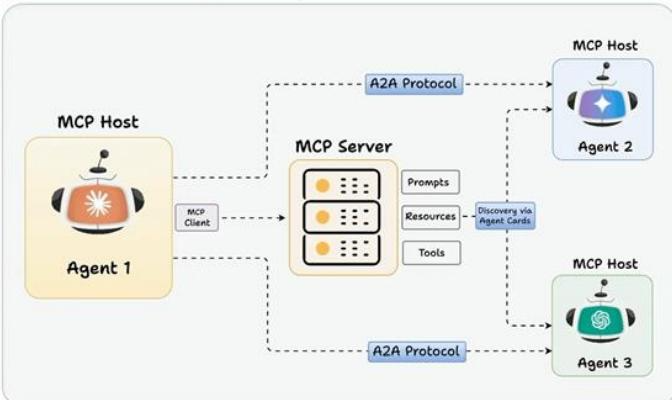

赋予LLM行动能力,将“思考”转化为落地动作:通过工具调用对接数据库、API、互联网等外部资源,编排任务执行流程,同时将结果反馈给LLM,形成“思考-行动-观察-再思考”的闭环。 - MCP服务:企业AI能力基石

作为连接企业IT资产与AI Agent的“桥梁”,MCP(模型上下文协议)服务通过标准化用户、AI Agent、LLM、后端服务的协同关系,将企业零散的财务、CRM、HR等系统转化为AI可调用的标准化能力,且无需改造原有系统或AI Agent,解决技能系统构建痛点。

二、AI Agent的核心定义与构建路径

1. AI Agent的本质与核心要素

AI Agent是具备“自主循环能力”的系统,需满足三大核心条件:基于LLM推理、通过工具执行行动、遵循“思考(Think)→执行(Action)→自省(Observe)→纠错”循环,区别于Chatbot的关键是能解决“复合、复杂、多步骤”问题(如跨领域业务协同)。其核心组件包括:

- 大脑(LLM):需根据业务场景选择适配模型(如通义千问、Gemini),负责意图识别与决策。

- 记忆(存储服务):基于NoSQL或向量数据库实现,分长期记忆(目标、偏好)与短期记忆(交互记录),支撑多步骤执行。

- 手(工具/MCP Server):提供外部业务能力(如数据库查询、文件读写),执行LLM决策。

- 指令(System Prompt):定义AI Agent的目标与行为边界。

2. 企业构建AI应用的两大路径

| 路径类型 | 核心逻辑 | 优势 | 典型场景 |

|---|---|---|---|

| 全新开发 | 从零设计原生AI应用,无历史技术债务 | 采用先进架构,最大化AI Agent能力,实现颠覆式创新 | 金融AI研究分析师、企业“超级知识入口” |

| 存量改造 | 在现有ERP、CRM等核心系统中嵌入AI Agent | 直接作用于核心业务流程,价值释放路径短、明确 | 传统CRM智能化升级、OA办公流程AI优化 |

三、关键技术支撑:函数计算(FC)与云原生API网关

1. 函数计算(FC):AI Agent的运行时与沙箱底座

FC是事件驱动的全托管计算服务,为AI Agent提供“运行时(Runtime)”与“沙箱(Sandbox)”两大核心支撑,是AI应用落地的关键基础设施:

- 核心特性:支持0.05C16C CPU、1GB48GB GPU实例,百毫秒级弹缩,免运维且集成20+云产品触发器(OSS、SLS等),适配多语言运行环境。

- 两大核心场景:

- AI Agent运行时:部署自研AI Agent(基于LangChain、Spring AI Alibaba等框架)或托管组件(如OpenManus、ComfyUI),通过触发器灵活调度,按请求扩缩降本。

- AI Agent沙箱:提供安全隔离环境,解决代码执行、网络隔离、资源管控问题,核心沙箱类型包括Code Sandbox(执行LLM/用户代码)、Browser Use Sandbox(数据采集/联网搜索)、RL Sandbox(强化学习训练)、Sim Sandbox(具身智能仿真)。

2. 云原生API网关:AI应用的统一管控中枢

网关融合流量网关、API网关、AI网关、MCP网关能力,解决AI应用的流量管控、安全防护、模型/MCP管理问题:

- AI网关核心价值:针对LLM使用痛点提供解决方案,如通过多API Key轮询突破QPS限制、集成联网搜索降低模型幻觉、LLM服务Fallback保障高可用、内容安全检查满足合规要求。

- MCP网关核心价值:实现传统服务0代码转MCP Server(基于MSE Nacos),将SSE协议转为Streamable HTTP(解决长连接弊端),降低企业接入MCP的成本。

四、MCP协议:AI与企业资源的“通用接口”

MCP(模型上下文协议)是Anthropic开源的通用协议,类比“AI领域的USB-C接口”,标准化LLM与外部工具/数据源的交互,解决定制化集成问题:

- 核心优势:标准化交互方式、模块化组件设计、可扩展性强、内置安全验证,区别于Function Calling(厂商专有能力,集成成本高),MCP支持跨厂商协作与成果复用。

- 企业级落地:MSE Nacos作为MCP Registry

MSE Nacos(微服务注册配置中心)作为MCP Registry超集,提供MCP Server注册/发现、安全管控(Prompt加密、敏感过滤)、0代码转换(传统服务转MCP)、多版本管理等能力,弥补官方MCP Registry的私有化、安全管控短板。

五、AI应用可观测体系:保障稳定与效果

针对AI应用的基础资源(GPU掉卡、网络延迟)、模型推理(性能慢、结果不合规)、成本(Token消耗不透明)三大挑战,报告提出全链路可观测方案:

- 核心能力:基于Prometheus构建全栈监控大盘(GPU资源、Token成本、模型性能)、OpenTelemetry实现全链路追踪(记录Prompt、Token消耗、推理步骤)、日志二次评估(合规性、意图提取)。

- 关键实践:Python无侵入探针(适配LLM框架,性能优于开源方案)、流式场景分段采集(平衡客户端性能与数据分析易用性)、vLLM/SGLang推理性能监控(定位排队请求、TPOT异常等问题)。

六、企业价值与新范式影响

- 架构变革:推动企业采用Serverless架构,实现业务功能最小粒度拆分与弹性扩缩(如高德业务投放平台实践,降低资源成本30%+)。

- 开发模式升级:基于“MCP Server First”理念,企业通过丰富MCP服务库,结合低代码平台(如阿里云AIStudio)实现“拖拖拽拽构建AI流程”,降低开发门槛。

- 效率提升:业务流程以自然语言描述需求,AI Agent自动调用MCP服务完成协同,减少跨团队沟通成本,加速创新落地。

© 版权声明

免费分享是一种美德,知识的价值在于传播;

本站发布的图文只为交流分享,源自网络的图片与文字内容,其版权归原作者及网站所有。

THE END

暂无评论内容