视频模型迎来GPT时刻,海外大厂加码AI投资

【原报告在线阅读和下载】:20251008【MKList.com】计算机行业2025年10月投资策略:视频模型迎来GPT时刻,海外大厂加码AI投资 | 四海读报

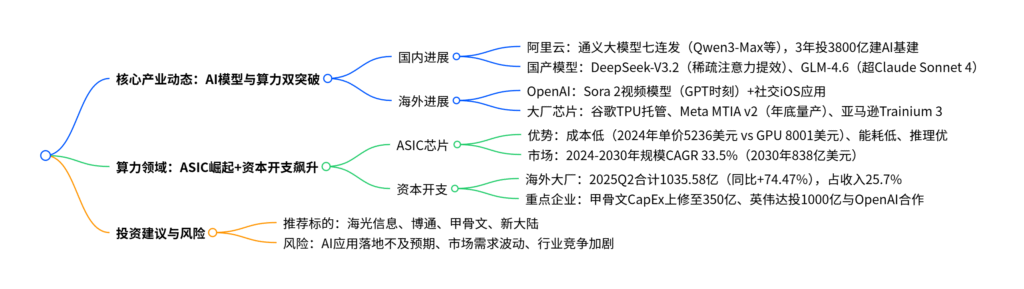

1. 一段话总结

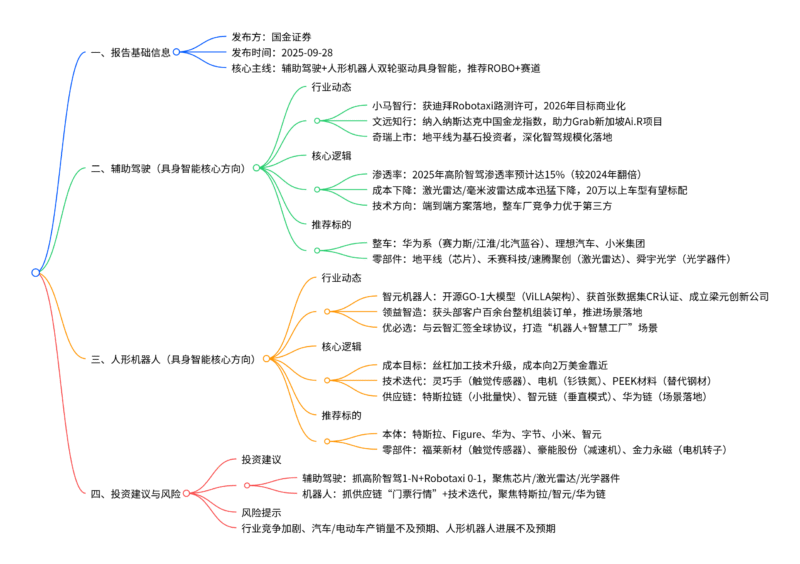

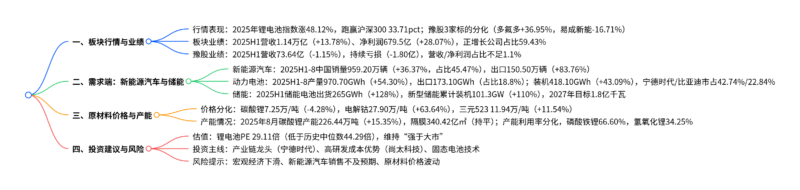

该报告为2025年10月7日国信证券发布的计算机行业投资策略,指出全球AI产业加速推进,核心亮点包括:阿里云栖大会发布7款通义大模型(如Qwen3-Max),未来三年投入超3800亿元建设AI硬件基础设施;海外大厂加码ASIC芯片(谷歌TPU授权第三方托管、Meta MTIA v2年底量产),2024-2030年ASIC芯片市场规模CAGR达33.5%;全球资本开支白热化,2025Q2海外大厂(微软、谷歌等)合计资本开支1035.58亿美元(同比+74.47%),甲骨文RPO达4550亿美元(同比+359%);OpenAI发布Sora 2视频生成模型(进入GPT时刻),国产模型(DeepSeek-V3.2、GLM-4.6)快速迭代;投资建议关注AI应用及算力标的(海光信息、博通等),同时提示应用落地不及预期等风险。

2. 思维导图(mindmap)

3. 详细总结

一、国内AI产业进展:阿里云领衔,国产模型迭代

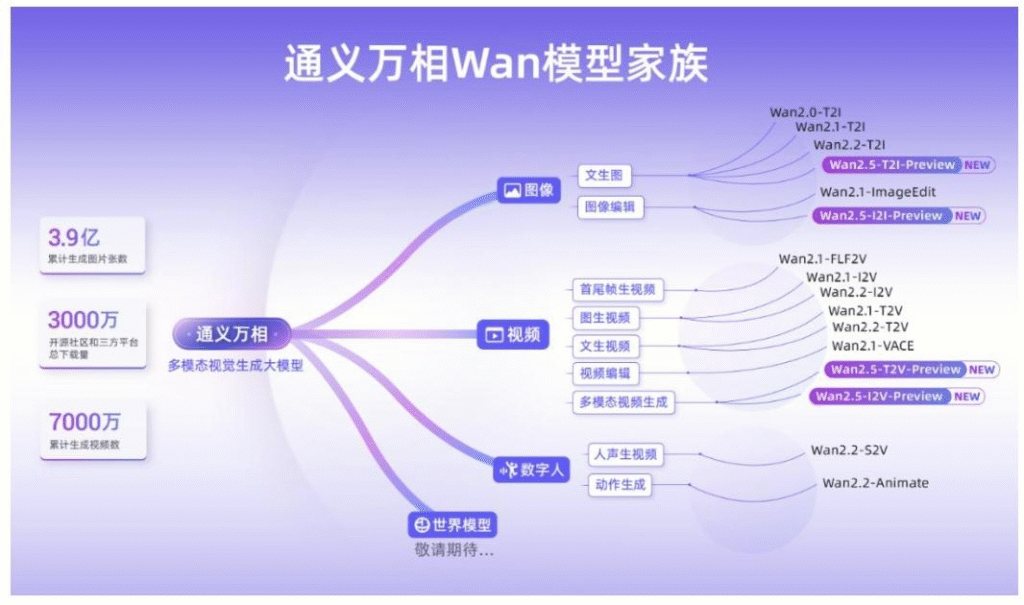

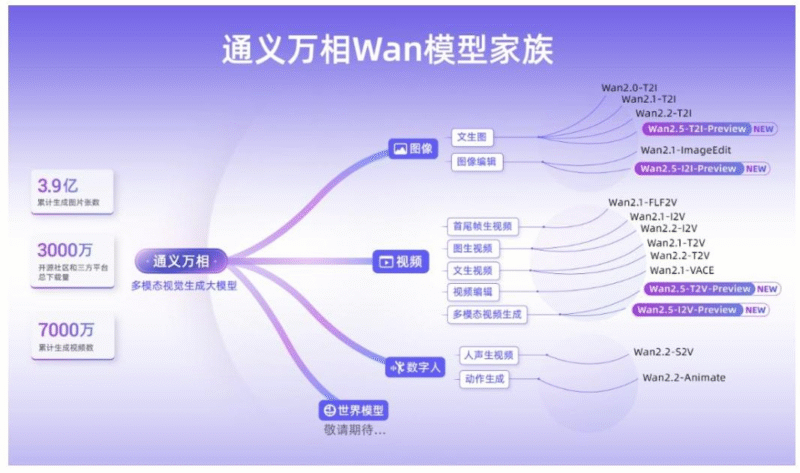

(一)阿里云栖大会:通义大模型七连发+3800亿基建投入

-

通义大模型家族升级

阿里云发布7款通义大模型,覆盖基础模型、多模态、专项场景,核心亮点如下:模型名称 核心能力 关键数据/测评表现 Qwen3-Max Coding+Agent工具调用 SWE-Bench 69.6分(全球第一梯队)、Tau2 Bench 74.8分 Qwen3-Next 高稀疏MoE架构 训练成本降90%、长文本推理吞吐量提10倍 Qwen3-VL 视觉理解+3D检测 32项测评超Gemini-2.5-Pro/GPT-5 Qwen3-Omni 全模态处理(文本/图像/音频/视频) 实时流式响应,支持百万tokens上下文 通义万相2.5 音画同步视频生成 10秒1080P视频,支持图像编辑 -

全栈AI能力布局

- 硬件:发布磐久128超节点AI服务器(单柜128个AI芯片)、HPN8.0网络(GPU互联带宽6.4Tbps);

- 存储:CPFS单客户端吞吐40GB/s、OSS Vector Bucket成本降95%;

- 全球化:新增巴西/法国/荷兰节点,扩建5国数据中心。

-

长期规划

首次阐述通往ASI(人工超级智能)三阶段路线,未来三年投入超3800亿元建设云和AI硬件基础设施。

(二)国产模型快速迭代

- DeepSeek-V3.2-Exp:引入稀疏注意力机制,长文本推理效率提升,用户API成本降低50%以上,已适配寒武纪、海光信息等国产芯片。

- 智谱AI GLM-4.6:上下文窗口扩至200K,多个基准超Claude Sonnet 4/4.5,在寒武纪芯片实现FP8+Int4混合量化部署(推理成本降30%+)。

二、海外AI进展:ASIC芯片崛起+资本开支白热化

(一)ASIC芯片成为推理场景核心选择

-

ASIC芯片优势

- 成本优势:2024年AI ASIC平均单价5236美元,低于GPU的8001美元(IDC数据);

- 能耗优势:同等算力下功率更低,适合大规模推理场景;

- 推理优势:谷歌TPU v5e覆盖低成本/主流/大模型推理,Meta MTIA v2 FP16算力354 TFLOPS(TDP 90W)。

-

大厂布局

企业 芯片产品 关键参数 量产计划 谷歌 TPU v7(Ironwood) 峰值4614 TFLOPS,能效超上一代2倍 2026年大规模放量 Meta MTIA v2 5nm工艺,FP16 354 TFLOPS 2025年底量产 亚马逊 Trainium 3 3nm工艺,算力提2倍、能效提40% 2025年底量产 -

谷歌TPU开放托管:授权Fluidstack等第三方服务商托管,扩大使用范围,降低对英伟达依赖。

(二)全球资本开支飙升

-

整体规模:2025Q2海外五大厂(微软、谷歌、亚马逊、Meta、甲骨文)合计资本开支1035.58亿美元(同比+74.47%),占收入比重25.7%(历史峰值)。

-

重点企业表现

企业 2025Q2资本开支(亿美元) 同比增速 关键动作 甲骨文 – – RPO 4550亿(同比+359%),CapEx上修至350亿 微软 242 +27.37% 2026财年CapEx指引660-720亿 谷歌 224 +70.23% 全年CapEx上修至850亿(同比+62%) Meta 170 +100.85% 全年CapEx指引660-720亿(中值同比+77%) 亚马逊 314 +91.46% 全年CapEx或超1200亿 -

重大合作:英伟达与OpenAI合作,部署10吉瓦英伟达系统,英伟达投1000亿美元,2026年下半年上线。

三、AI应用突破:Sora 2开启视频模型GPT时刻

-

Sora 2核心升级

- 生成能力:支持现实/电影/动漫风格,模拟复杂物理效果(如浮力、刚性);

- 多模态:生成复杂背景声效、语音,支持现实元素注入(还原人物外貌/声音);

- 应用落地:发布社交iOS应用,支持用户创作/混合内容,美国、加拿大首轮上线。

-

产业意义:标志视频生成模型从“GPT-1”跃升至“GPT-3.5”阶段,商业化场景大幅拓宽。

四、投资建议与风险提示

(一)投资建议

聚焦AI应用及算力产业链,重点推荐标的如下:

| 标的代码 | 标的名称 | 核心逻辑 | 2025E PE |

|---|---|---|---|

| 688041.SH | 海光信息 | 国产算力龙头,适配主流AI模型 | 149.47 |

| AVGO.O | 博通 | 高端芯片供应商,受益算力需求 | 61.97 |

| ORCL.N | 甲骨文 | 云基建龙头,RPO高速增长 | 43.26 |

| 000997.SZ | 新大陆 | AI应用落地,业务协同性强 | 25.05 |

(二)风险提示

- AI应用落地不及预期:模型商业化进度滞后于技术迭代;

- 市场需求波动:宏观经济影响企业AI投入;

- 行业竞争加剧:芯片、模型领域参与者增多,价格战风险;

- 新技术研发不及预期:ASIC、大模型技术突破滞后。

4. 关键问题

问题1:阿里云在AI领域的核心布局与长期规划是什么?其发布的通义大模型有哪些关键突破?

答案:

- 核心布局与规划:阿里云从“模型、硬件、全球化”三方面构建全栈AI能力,模型端发布7款通义大模型覆盖全场景,硬件端推出磐久128超节点服务器、HPN8.0高性能网络,全球化端新增3个地域节点并扩建5国数据中心;长期规划首次阐述通往ASI的三阶段路线(智能涌现→自主行动→自我迭代),未来三年投入超3800亿元建设云和AI硬件基础设施。

- 通义大模型关键突破:①Qwen3-Max在SWE-Bench(69.6分)、Tau2 Bench(74.8分)测评中位列全球第一梯队;②Qwen3-Next采用高稀疏MoE架构,训练成本降90%、长文本推理吞吐量提10倍;③Qwen3-VL实现3D检测能力,32项测评超Gemini-2.5-Pro/GPT-5;④通义万相2.5首次实现音画同步视频生成(10秒1080P)。

问题2:ASIC芯片为何成为海外大厂在AI推理场景的重点选择?其市场规模与头部企业进展如何?

答案:

- 核心原因:①成本优势,2024年AI ASIC平均单价5236美元,低于GPU的8001美元,长期单价更稳定;②能耗优势,定制化设计使其在特定推理任务中功率更低,适配大规模数据中心;③推理适配性,谷歌TPU v5e、Meta MTIA v2等产品细分推理场景,覆盖低成本到高端大模型需求。

- 市场规模:2024年ASIC芯片市场规模148亿美元,预计2030年达838亿美元,2024-2030年CAGR33.5%(高于GPU的29.2%);出货量2024年283万颗,2030年达1431万颗,CAGR31.0%。

- 头部进展:谷歌TPU v7(Ironwood)峰值算力4614 TFLOPS(2026年量产),Meta MTIA v2(5nm,354 TFLOPS,2025年底量产),亚马逊Trainium 3(3nm,算力提2倍,2025年底量产),谷歌还授权第三方托管TPU以扩大生态。

问题3:2025年全球AI资本开支呈现哪些特征?OpenAI与英伟达的合作对产业有何影响?

答案:

- 资本开支特征:①规模飙升,2025Q2海外五大厂合计资本开支1035.58亿美元(同比+74.47%),占收入比重25.7%(历史峰值);②大厂加码,微软2026财年CapEx指引660-720亿,谷歌上修至850亿(同比+62%),Meta上修至660-720亿(中值同比+77%);③聚焦AI基建,甲骨文RPO达4550亿美元(同比+359%),超200万芯片用于星际之门项目。

- 合作影响:英伟达与OpenAI合作部署10吉瓦系统(用于下一代模型训练/运行),英伟达投1000亿美元,2026年下半年上线,将:①进一步推高全球AI硬件需求,拉动芯片、服务器产业链;②加速超级AI部署,推动模型能力从“视频生成”向更复杂场景突破;③强化英伟达在AI算力生态的主导地位,同时倒逼其他厂商加大ASIC芯片研发投入。

暂无评论内容