AI算力跟踪深度(四):怎么看算力的天花板和成长性?

【原报告在线阅读和下载】:20251016【MKList.com】AI算力跟踪深度(四):怎么看算力的天花板和成长性? | 四海读报

【迅雷批量下载】:链接:https://pan.xunlei.com/s/VOXJ23RJHhoECPL5FRrVathfA1 提取码:umqb

【夸克批量下载】:链接:https://pan.quark.cn/s/fe42cc605010 提取码:j4Vv

1. 一段话总结

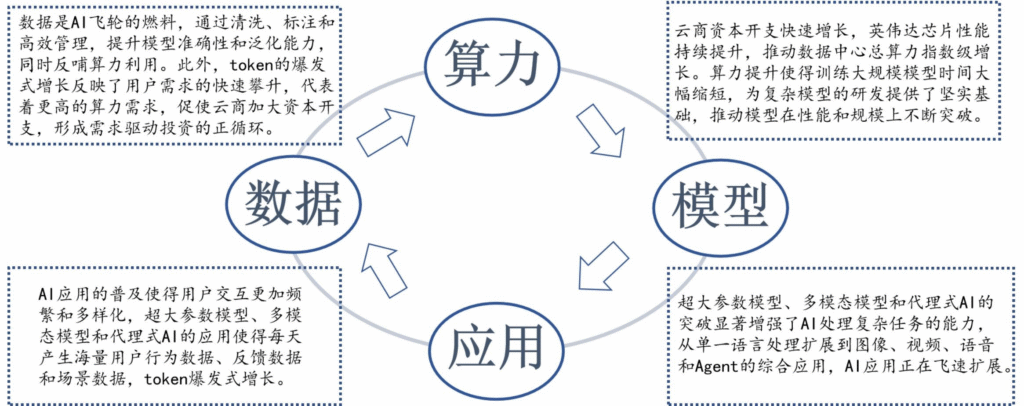

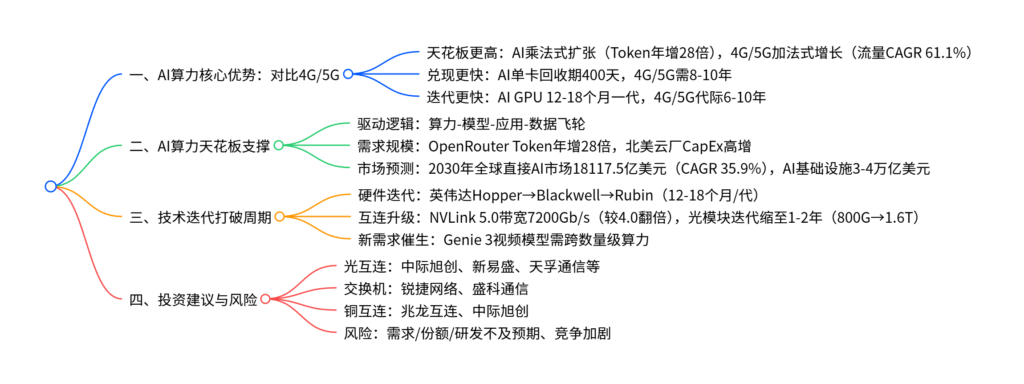

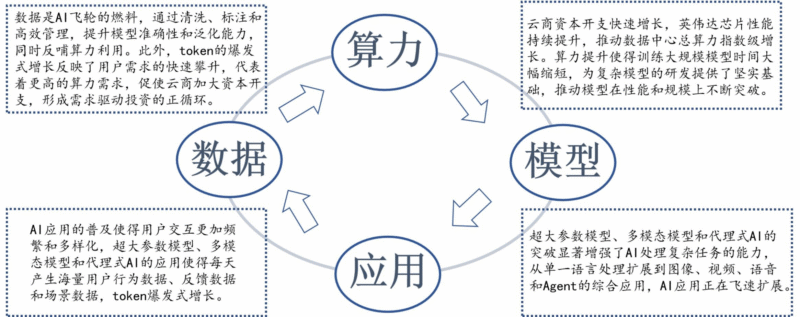

本报告(东吴证券2025年10月15日发布)指出,AI算力相比4G/5G具备更高天花板与更快成长性:AI以“算力-模型-应用-数据”飞轮驱动乘法式扩张(OpenRouter平台Token消耗量一年增长28倍),行业天花板由可智能化任务空间决定,而4G/5G受频谱、站址等物理约束呈加法式增长;AI投资滚动式兑现(H100单卡回收期约400天,4G/5G需8-10年),且技术迭代速度更快(GPU12-18个月一代,4G/5G代际跨越6-10年),通过“年更+软硬协同”打破传统量价周期;未来随着Genie 3等新需求涌现,算力需求将持续提升,建议关注光互连(中际旭创、新易盛)、交换机(锐捷网络)、铜互连(兆龙互连)等标的,风险主要来自算力需求、客户份额、研发落地不及预期及行业竞争加剧。

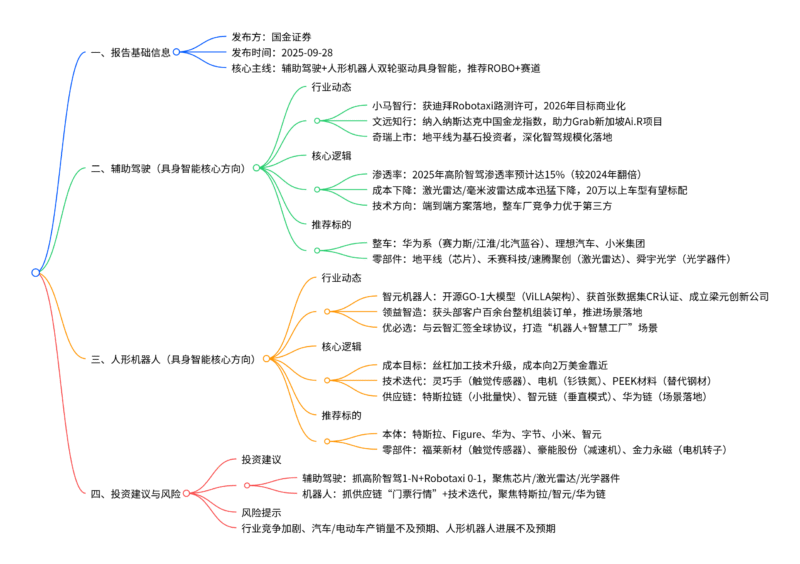

2. 思维导图(mindmap)

3. 详细总结

一、报告基础信息

| 项目 | 内容 |

|---|---|

| 报告类型 | AI算力行业深度跟踪报告(第四篇) |

| 发布机构 | 东吴证券 |

| 发布日期 | 2025年10月15日 |

| 核心分析师 | 张良卫(S0600516070001)、李博韦(S0600525070006) |

| 核心逻辑 | AI算力凭借高天花板、快兑现、快迭代优势,成长空间远超4G/5G,聚焦互连与硬件环节标的 |

二、AI算力 vs 4G/5G:核心差异对比

1. 天花板:AI呈“乘法式”扩张,4G/5G受物理约束

AI与4G/5G在增长逻辑、边界约束及需求规模上存在本质差异,具体如下表:

| 对比维度 | AI算力 | 4G/5G | 关键数据支撑 |

|---|---|---|---|

| 增长逻辑 | 乘法式扩张(智能产出×全要素生产率) | 加法式增长(基建CAPEX+运营收入) | AI:OpenRouter Token年增28倍;4G/5G:流量CAGR 61.1%(2013-2024) |

| 边界约束 | 无界(可智能化任务空间决定) | 物理约束(频谱、站址、人口/设备密度) | 5G:国内运营商CAPEX 2022年见顶,2023-2024趋稳 |

| 市场规模 | 持续上修 | 收敛性TAM | 2030年AI基础设施3-4万亿美元(英伟达预测);4G/5G:全球直接市场规模增速<5% |

2. 兑现速度:AI“边部署边变现”,4G/5G回收期长

AI算力通过按量计费、高利用率实现快速回本,而4G/5G受重资本、慢变现制约,具体差异如下:

| 对比维度 | AI算力 | 4G/5G | 关键数据支撑 |

|---|---|---|---|

| 投资主体 | 超大规模云服务商、专业GPU云商 | 运营商 | AI:北美四大云厂2025Q1 CapEx超800亿美元;4G/5G:国内三大运营商年CAPEX约3000亿元 |

| 资产生命周期 | 2-3年(GPU快速迭代) | 8-10年(基站、光纤) | AI:H100单卡成本3万美元,回收期约400天;4G/5G:平均回收期8-10年 |

| 变现模式 | 按量计费(4/GPU·h) | 订阅制(ARPU增速慢) | AI:AWS p5.48xlarge折算$3.933/GPU·h;4G/5G:高收入市场ARPU年增仅1%(GSMA预测) |

| 用户渗透 | 超高速(ChatGPT 3年8亿用户) | 缓慢(互联网12-13年达8亿用户) | AI:用户获客成本比互联网低50%+,付费转化率高 |

3. 技术迭代:AI“12-18个月/代”,4G/5G周期长

AI算力通过高频迭代打破传统量价周期,4G/5G受标准与产业链约束迭代缓慢:

| 对比维度 | AI算力 | 4G/5G | 关键数据支撑 |

|---|---|---|---|

| 迭代周期 | 12-18个月(GPU+软硬协同) | 6-10年(代际跨越) | AI:英伟达Hopper(2022)→Blackwell(2024)→Rubin(2026);4G/5G:LTE(2008)→5G(2018)→5G-A(2024) |

| 核心升级 | GPU+互连+存储协同 | 标准+基站+终端 | AI:NVLink 5.0带宽7200Gb/s(较4.0翻倍);4G/5G:Release标准18-24个月/次 |

| 量价周期 | 新代提价、旧代有底价 | 量增价跌(年降10-15%) | AI:光模块龙头毛利率稳步提升(中际旭创2025Q2毛利率40%+);4G/5G:基站ASP年降12-15% |

三、AI算力成长性支撑:技术迭代与新需求

1. 技术迭代:硬件与互连持续升级

-

GPU迭代:英伟达平台从Hopper(2022)→Blackwell(2024)→Rubin(2026),每代算力提升2-3倍,HBM容量从80GB(H100)→192GB(B100)→384GB(Rubin)。

-

互连升级:

- NVLink:版本从4.0(3600Gb/s)→5.0(7200Gb/s),带宽翻倍,支持多GPU集群高效协同。

- 光模块:迭代周期从3-4年缩至1-2年,800G成为当前主流,1.6T 2025年起上量,LPO技术使功耗减半(7.5W vs 15W)。

-

存储升级:HBM3E(2024Q2上量)→HBM4(2025年量产),带宽从1.1TB/s→2.0TB/s,满足大模型上下文需求。

2. 新需求催生:杰文斯悖论持续演绎

当算力成本下降、可用性提升时,开发者会提出更复杂需求,推动算力需求跨数量级增长:

- 模型复杂度提升:GPT-MoE 1.8T参数模型推理需GB200集群支持,单GPU性能较H200提升30%+。

- 多模态应用:Genie 3等生成视频模型需算力较文本模型提升100-1000倍,当前算力仍无法满足大规模商用。

- 行业渗透:AI在工业、医疗、自动驾驶等领域的深度应用(如实时质检、精准诊疗),催生增量算力需求。

四、投资建议与风险提示

1. 投资建议:聚焦三大方向

| 投资方向 | 核心标的 | 逻辑支撑 |

|---|---|---|

| 光互连 | 中际旭创、新易盛、天孚通信、光库科技 | 800G/1.6T光模块需求高增,LPO技术落地降本,龙头毛利率稳步提升 |

| 交换机 | 锐捷网络、盛科通信 | AI数据中心Scale Up需求推动高端口速率交换机(如512-port 100G)出货增长 |

| 铜互连 | 兆龙互连、中际旭创 | 高带宽 Twinax电缆需求增加,CPC+LPO技术提升互连效率 |

2. 风险提示

- 算力需求不及预期:若云厂商资本开支放缓或AI应用落地滞后,将导致算力硬件需求下降。

- 客户份额不及预期:光模块、交换机等领域竞争加剧,标的公司在客户处份额可能低于预期。

- 产品研发落地不及预期:1.6T光模块、LPO技术等研发进度滞后,影响业绩释放。

- 行业竞争加剧:新进入者增多导致价格战,挤压利润率(如光模块ASP年降超10%)。

4. 关键问题

问题1:AI算力“乘法式扩张”的核心逻辑是什么?相比4G/5G的“加法式增长”,其在天花板上的本质差异体现在哪些方面?

答案:

-

AI算力“乘法式扩张”的核心逻辑:AI以“算力-模型-应用-数据”飞轮驱动——算力提升支撑更大规模模型训练(如GPT-MoE 1.8T参数),模型能力增强催生多模态应用(文本→图像→视频),应用落地产生海量数据反哺模型迭代,形成正反馈,使算力需求呈指数级增长(如OpenRouter平台Token消耗量一年增长28倍)。

-

与4G/5G天花板的本质差异:

- 增长约束不同:4G/5G受物理边界限制(频谱资源有限、站址建设受地理/功耗制约),收入由“基建CAPEX+用户ARPU”加法决定,TAM收敛(国内运营商CAPEX 2022年见顶);AI算力无物理约束,天花板由“可智能化的任务空间”决定(如工业质检、自动驾驶等未饱和场景),随技术迭代持续上修。

- 产出价值不同:4G/5G产出“连接与流量”,价值随用户数/设备数线性增长;AI产出“智能”,作为生产要素与数据、劳动力相乘提升全要素生产率,单算力单位创造的经济价值远超流量(如AI质检效率较人工提升10倍)。

- 市场规模不同:2030年AI基础设施规模预计3-4万亿美元(英伟达预测),全球直接AI市场CAGR 35.9%;4G/5G全球市场增速不足5%,且受折旧、能耗制约,长期增长乏力。

问题2:AI算力投资“滚动式兑现”的具体体现是什么?其回收期远短于4G/5G的关键原因有哪些?

答案:

-

AI算力“滚动式兑现”的具体体现:AI算力投资无需等待全量覆盖,可“边部署边变现”——云服务商按GPU卡时计费(如AWS p5.48xlarge $3.933/GPU·h),设备上线即产生现金流;同时,高算力需求使GPU利用率维持90%+,提前锁定RPO(如甲骨文RPO同比增359%),快速摊薄前期投入。

-

回收期短于4G/5G的关键原因:

- 变现模式差异:AI算力采用“按量计费”,单卡收入高(H100单卡年营收约2.6万美元),回收期约400天;4G/5G采用“订阅制”,ARPU提价受限(高收入市场年增1%),且需承担频谱拍卖成本(如德国5G频谱竞拍65.5亿欧元),回收期长达8-10年。

- 资产生命周期差异:AI算力核心资产(GPU、光模块)生命周期2-3年,迭代快且残值高;4G/5G核心资产(基站、光纤)生命周期8-10年,折旧压力大,且需二次建设(如5G-A)拉长回收周期。

- 用户渗透差异:AI产品(如ChatGPT)3年获8亿用户,获客成本低且付费转化率高(企业版ARPU超1000美元/月);4G/5G用户渗透依赖终端替换(如5G手机渗透率达80%用了5年),用户付费意愿弱。

问题3:AI算力技术迭代如何打破传统硬件“量价周期”?未来哪些技术方向将进一步支撑算力成长性?

答案:

-

AI算力打破传统量价周期的机制:传统硬件(如4G/5G基站)呈“量增价跌”周期(建设初期量增、后期价跌幅度大于量增);AI算力通过“12-18个月高频迭代+软硬协同”,在旧代产品价格下行前,以“新代际价值锚”重定价——例如:

- GPU迭代:英伟达Blackwell(2024)较Hopper(2022)算力提升2倍,单卡价格提价30%+,同时旧代H100因需求旺盛仍维持底价(无大幅降价)。

- 互连升级:光模块从400G→800G→1.6T,每代产品在量增前先实现价涨(800G光模块均价较400G高50%),龙头毛利率稳步提升(中际旭创2025Q2毛利率40%+)。

-

支撑未来算力成长性的技术方向:

- 硬件升级:GPU向Rubin平台(2026年)演进,HBM4容量达384GB,算力较Blackwell提升2-3倍;异质集成(TFLN-on-SiPho)实现单通道400G,支撑3.2T光模块商用。

- 互连优化:LPO技术进一步降功耗(从7.5W→5W),CPC替代PCB走线减少信号损耗,NVLink 6.0带宽突破10000Gb/s,提升集群协同效率。

- 新需求技术:针对Genie 3等视频模型,开发专用AI芯片(如视频生成加速卡),降低单位算力成本,推动多模态应用规模化落地。

暂无评论内容